1

1 1

1

Meta は、テクノロジー分野で最大のワークロードの一部を処理できるハイパースケール AI インフラストラクチャの構築を目的とした Nvidia との複数年にわたるパートナーシップを発表しました。

この提携により、数百万の GPU と Arm ベースの CPU が導入され、ネットワーク容量が拡張され、高度なプライバシー保護コンピューティング テクノロジーが同社のプラットフォーム全体に統合されます。

この取り組みは、Meta の広範なプロダクション ワークロードを Nvidia のハードウェアおよびソフトウェア エコシステムと組み合わせて、パフォーマンスと効率を最適化することを目指しています。

両社は、オンプレミスのデータセンターと Nvidia クラウド パートナーの展開にまたがる統合インフラストラクチャ アーキテクチャを構築しています。

このアプローチは、AI のトレーニングと推論のためのスケーラブルで高性能なコンピューティング リソースを提供しながら、操作を簡素化します。

Nvidia の創設者兼 CEO のジェンセン ファンは次のように述べています。「メタ規模で AI を導入する人はいません。最先端の研究と産業規模のインフラストラクチャを統合して、数十億のユーザー向けの世界最大のパーソナライゼーションおよびレコメンデーション システムを強化します」と述べています。

「CPU、GPU、ネットワーキング、ソフトウェアにわたる綿密な共同設計を通じて、次の AI フロンティアの基盤を構築する Meta の研究者やエンジニアに完全な Nvidia プラットフォームを提供します。」

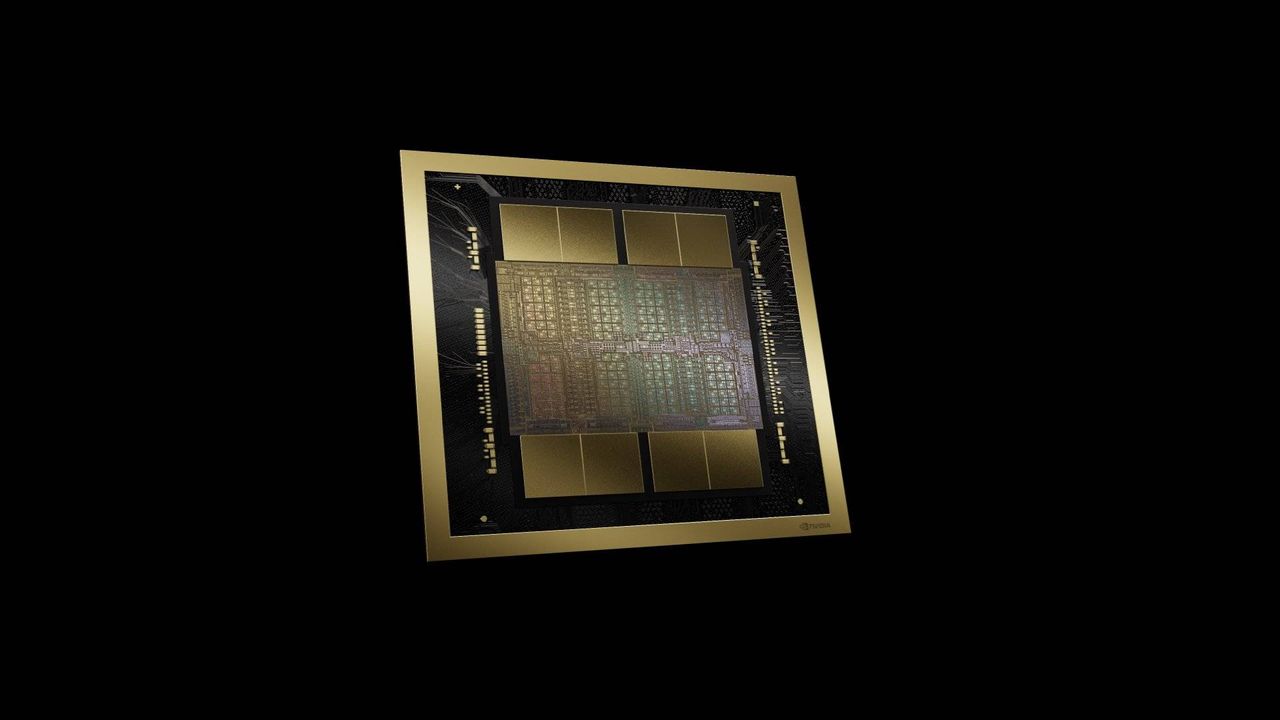

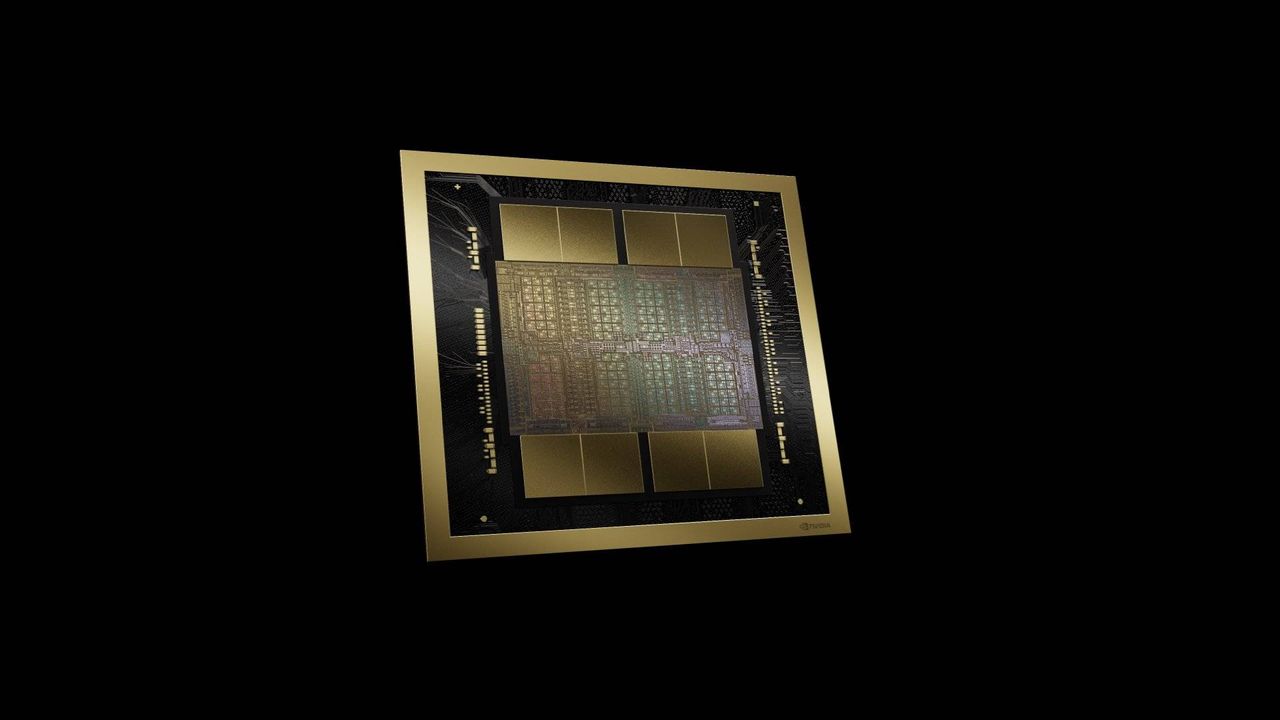

Nvidia の GB300 ベースのシステムは、これらの導入のバックボーンを形成します。彼らは、次世代 AI モデルの要求を満たすために、コンピューティング、メモリ、ストレージを統合するプラットフォームを導入します。

Meta はまた、Nvidia Spectrum-X イーサネット ネットワーキングを地域全体に拡張し、大規模なワークロードの運用効率とエネルギー効率を向上させながら、予測可能な低遅延パフォーマンスを提供することを目指しています。

Meta は、WhatsApp 内で AI を活用した機能をサポートするために Nvidia Confidential Computing の採用を開始し、プライバシーと整合性を維持しながら機械学習モデルがユーザー データを処理できるようにしました。

この提携では、このアプローチを他のメタ サービスに拡張し、プライバシーを強化する AI テクノロジーを複数のアプリケーションに統合する予定です。

Meta と Nvidia のエンジニアリング チームは協力して AI モデルをコーディングし、インフラストラクチャ スタック全体でソフトウェアを最適化しています。

ハードウェア、ソフトウェア、ワークロードを調整することで、両社はワットあたりのパフォーマンスを向上させ、最先端のモデルのトレーニングを加速することを目指しています。

Nvidia Grace CPU の大規模導入はこの取り組みの中核であり、今回のコラボレーションはこの規模での初の大規模な Grace のみの導入となります。

CPU エコシステム ライブラリにもソフトウェアの最適化が実装されており、後続世代の AI ワークロードのスループットとエネルギー効率が向上します。

Meta の創設者兼 CEO のマーク・ザッカーバーグは、「Nvidia とのパートナーシップを拡大し、Vera Rubin プラットフォームを使用して最先端のクラスターを構築し、世界中のすべての人にパーソナル スーパーインテリジェンスを提供できることを嬉しく思います」と述べています。

Google ニュースで TechRadar をフォローしてください そして お気に入りのソースとして追加してください 専門ニュース、レビュー、意見をフィードで入手するため。必ずフォローボタンをクリックしてください!

そしてはい、あなたもできます TikTokでTechRadarをフォローしてください ニュース、レビュー、ビデオ形式の開封、および当社からの定期的な更新情報については、 ワッツアップ とても。